近日,国际人工智能顶级会议 AAAI 2026(The 40th AAAI Conference on Artificial Intelligence)发来录用通知,5楼自拍

、电网环境保护全国重点实验室欧阳钞、白昱阳、张俊、高天露、孔丽君、高文忠,与中国大唐集团科技创新有限公司郝君撰写的论文《DisCo DETR: Distance-Aware Multi-View Contrastive Learning for DETR Pre-Training》成功被大会主会(Main Technical Track)录用。该研究针对当前主流的目标检测模型 DETR 提出了全新的预训练框架,通过架构对齐的创新设计,显著提升了模型的训练效率与检测精度。

会议背景:顶级盛会,竞争激烈

AAAI 人工智能会议(AAAI Conference on Artificial Intelligence)由国际先进人工智能协会主办,是人工智能领域的顶级国际学术会议之一,也是中国计算机学会(CCF)推荐的A类会议。第40届 AAAI 人工智能会议将于2026年1月20日至1月27日在新加坡召开。

本届会议的论文投稿量创下历史新高,竞争异常激烈。据官方数据显示,AAAI 2026 共收到了近 31,000 份摘要提交。经过严格筛选,最终进入第一阶段审查的论文为 23,680 篇,而最终被录用的论文仅 4,167 篇,整体录用率约为 17.6%。

成果解读:解决 DETR 预训练中的架构对齐问题

本文介绍的 DisCo DETR 成果,旨在解决基于 Transformer 的目标检测器(DETR)在自监督预训练阶段面临的架构不匹配问题,提出了一种高效的距离感知多视图对比学习框架。

1.研究背景与问题分析

DETR 模型通过引入“对象查询(Object Query)”和二分图匹配机制,实现了端到端的目标检测。然而,DETR 对大规模标注数据依赖性强,且训练收敛速度较慢。现有的自监督预训练方法虽然在一定程度上缓解了数据依赖,但在与DETR架构的深度对齐方面仍存在两大局限:

l定位信号的不稳定性:现有方法通常采用随机策略将图像特征注入到对象查询中。这种做法忽略了对象查询在DETR中承担的空间位置编码功能,导致预训练提供的监督信号不稳定,难以有效提升模型的定位能力与收敛效率。

l语义学习的机制冗余:目标检测包括定位和分类两个任务,在用于分类任务的特征判别学习中,现有方法往往依赖粗糙的伪标签或引入复杂的额外匹配步骤来构建对比学习任务。这种方式未能充分挖掘DETR原生的二分图匹配机制在跨视图一致性学习中的潜力——即利用模型自身推理产生的匹配结果来天然地构建正样本对。这不仅增加了计算开销,也限制了语义判别特征的学习效率。

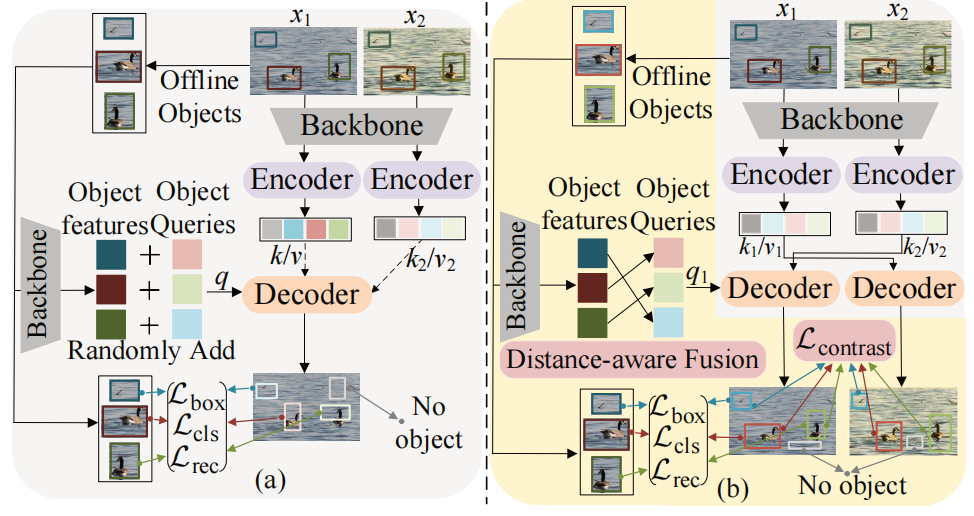

图 1:DETR的自监督预训练方法比较。(a)先前的方法。(b)DisCo DETR将跨视图特征融合到空间邻近的查询中,并通过原生二分匹配挖掘正样本对进行匹配对齐。

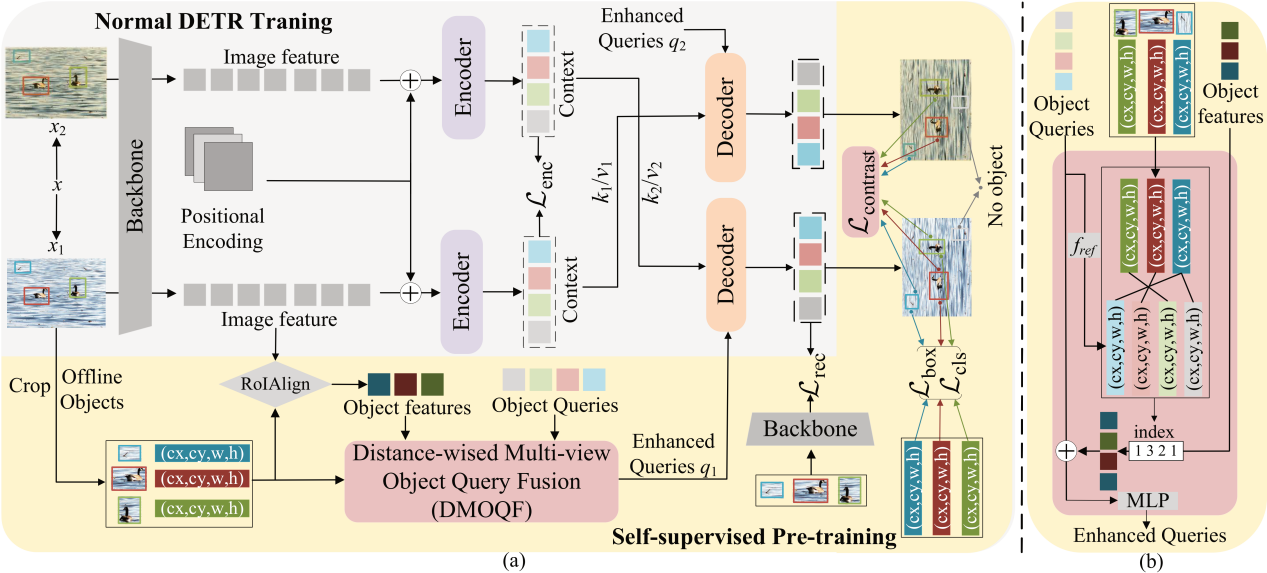

2.核心创新:距离感知融合与基于原生二分匹配的对比学习

为解决上述问题,研究团队提出了 DisCo DETR 框架,通过以下两个核心组件实现了预训练任务与 DETR 架构的深度对齐 :

l距离感知多视图对象查询融合 (DMOQF):针对随机注入特征导致的空间信息错位问题,团队提出了基于距离感知的融合策略以提升定位稳定性。该模块首先利用二分图匹配算法,在图像的对象建议框(Object Proposals)与模型的对象查询向量之间建立关联,确保特征仅被融合到空间位置最邻近的查询向量中。 这种显式的空间位置引导,使得模型能够获得稳定的监督信号,确立了查询向量与目标区域的对应关系,从而显著加速训练收敛并提升定位精度。

l基于原生二分匹配的对比学习 (CLD):对现有语义学习方法存在的计算冗余问题,团队创新性地挖掘了 DETR 架构自身特有的二分图匹配机制的潜力。不同于传统方法需要引入额外的匹配步骤或复杂的伪标签生成,CLD 模块直接利用DETR在推理过程中产生的原生匹配结果:当同一物体在不同视图下被检测时,模型自身的匹配机制即可天然地识别出对应的输出结果。基于这一特性,该模块能够零成本地构建高质量的正样本对进行对比学习,在无额外匹配计算开销的前提下,有效增强了模型对跨视图语义特征的判别能力。

图 2:DisCo DETR整体架构图

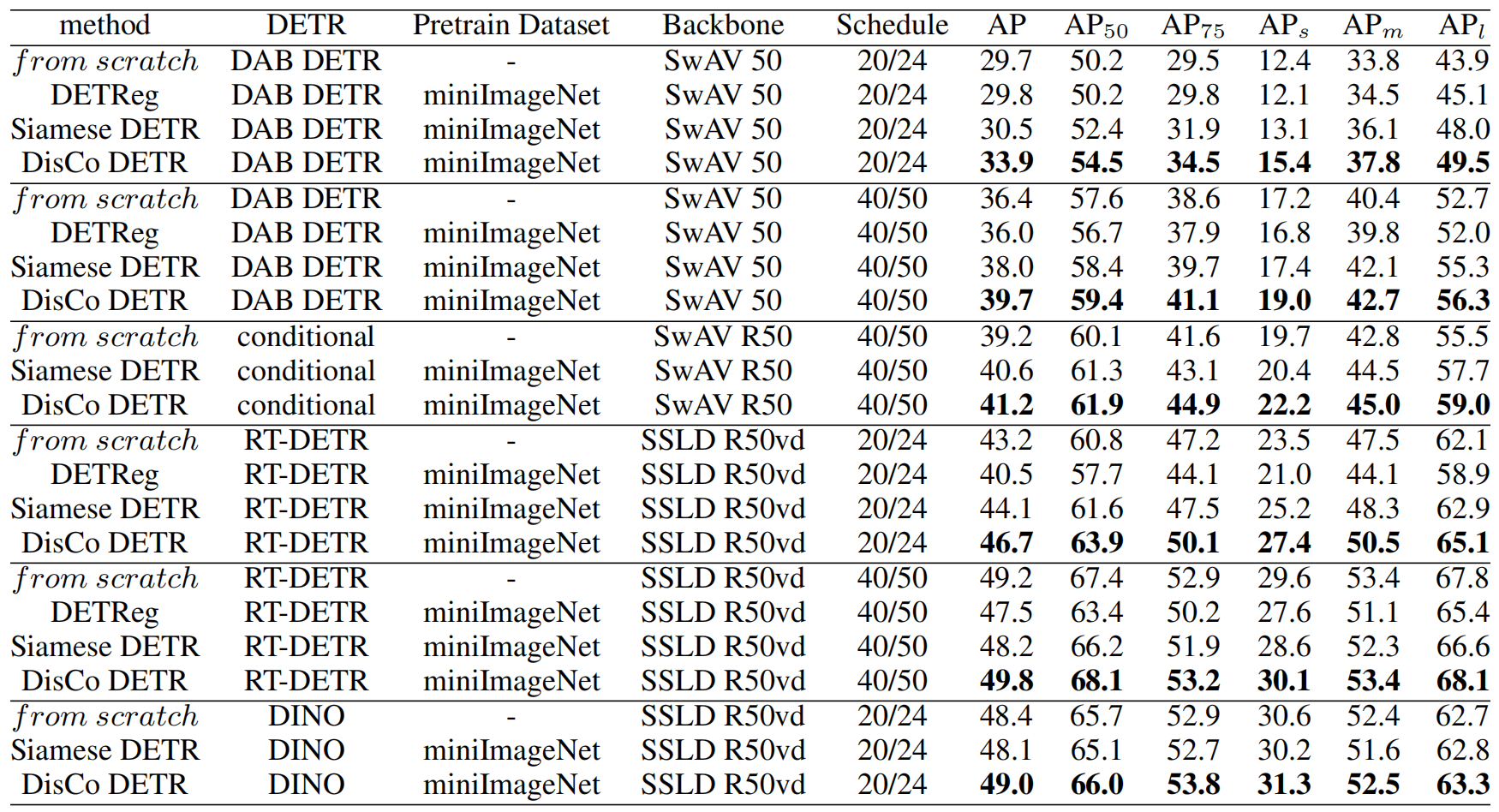

3.实验效果与价值

实验结果表明,DisCo DETR 具有极强的通用性,能够无缝集成到多种主流 DETR 变体中。在 PASCAL VOC 和 COCO 等权威基准测试中,该方法均取得了目前最优的迁移学习性能(SOTA)。特别是在训练周期较短的情况下,DisCo DETR 展现出了显著的收敛速度优势,大幅降低了训练成本,为DETR类模型的高效训练提供了新的解决方案。

图 3:COCO实验结果

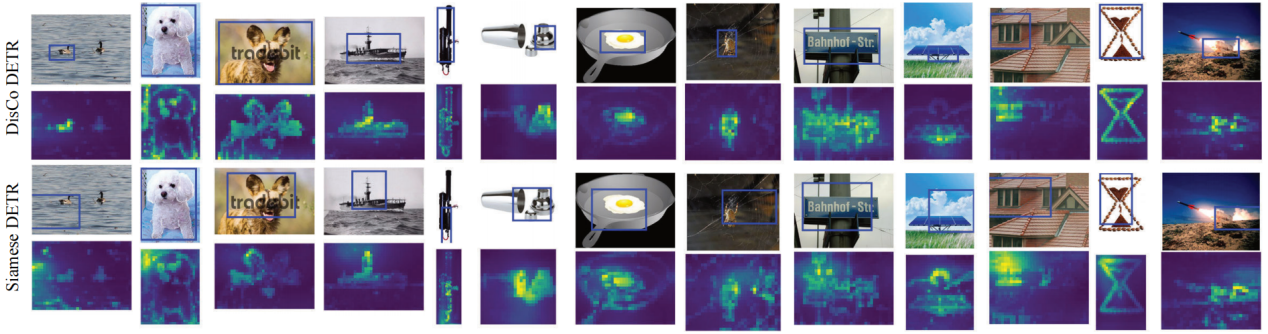

图 4:不同预训练方法下模型注意力与定位效果可视化图

本文介绍的研究成果展示了学院在人工智能领域的探索进展,欢迎探讨交流。

(审稿:曾福平 责编:华小梅)